Technologie : Cupertino explique ses plans pour maintenir l’intégrité de son système de lutte contre les contenus pédopornographiques.

Lorsqu’Apple a annoncé ses plans pour lutter contre les contenus pédopornographiques sur ses systèmes d’exploitation la semaine dernière, l’entreprise a précisé que le seuil fixé pour la désactivation des comptes faux positifs serait de un sur mille milliards par an.

Une partie des mécanismes par lesquels Apple est arrivé à ce chiffre a été publié dans un document (PDF) qui fournit plus de détails sur le système.

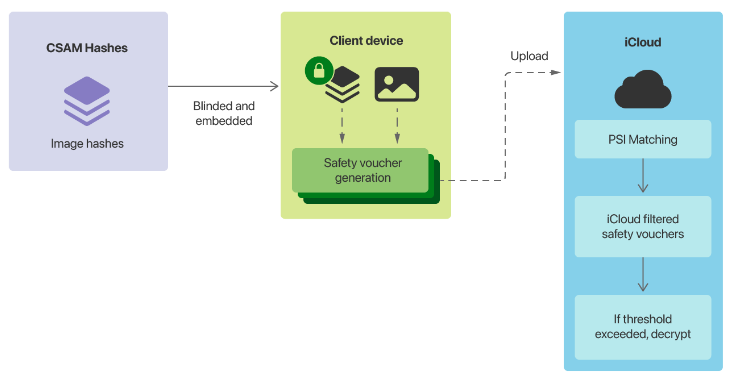

L’élément le plus controversé des plans de Cupertino est son système de détection de matériel pédopornographique (CSAM – child sexual abuse material) sur les appareils. Il s’agira pour les appareils Apple de comparer les images présentes sur l’appareil à une liste d’images connues, fournie par le Centre national américain pour les enfants disparus et exploités (NCMEC – National Center for Missing and Exploited Children) et d’autres organisations de protection de l’enfance, avant qu’une image ne soit stockée dans iCloud.

Croisement de plusieurs bases de données

Lorsqu’un seuil de signalement sera atteint, Apple inspectera les métadonnées téléchargées avec les images chiffrées dans iCloud et, si l’entreprise détermine qu’il s’agit de CSAM, le compte de l’utilisateur sera désactivé et le contenu sera transmis au NCMEC aux Etats-Unis.

Le document indique que ce sont les données de deux organisations de protection de l’enfance opérant dans des pays différents qui permettront de déterminer cela, et non pas une seule base de données.

Après avoir comparé les métadonnées de 100 millions d’images non-CSAM, Apple a trouvé trois faux positifs, et zéro lorsqu’elles étaient comparés à de la pornographie adulte. La société indique qu’en supposant un taux d’erreur « le plus défavorable » d’un sur un million, elle veut garantir un seuil de désactivation des faux positifs d’un sur mille milliards.

Une histoire de faux bons

Pour s’assurer que les serveurs iCloud d’Apple ne tiennent pas compte du nombre d’images CSAM positives d’un utilisateur, son appareil produira également de fausses métadonnées, qu’Apple appelle des bons de sécurité (safety vouchers). L’entreprise ajoute que ses serveurs ne seront pas en mesure de distinguer les vrais vouchers des faux, jusqu’à ce que le seuil soit atteint.

« Le processus de correspondance sur l’appareil remplacera, avec une certaine probabilité, un vrai bon de sécurité en cours de génération par un faux bon. Cette probabilité est calibrée pour que le nombre total de faux bons soit proportionnel au seuil de correspondance », explique Apple.

« Ces faux bons sont une propriété de chaque compte, et non du système dans son ensemble. Pour les comptes en-dessous du seuil de correspondance, seul l’appareil de l’utilisateur sait quelles pièces justificatives sont fausses ; les serveurs d’Apple ne déterminent pas et ne peuvent pas déterminer ce nombre, et ne peuvent donc pas compter le nombre de vraies correspondances positives. »

Contrôle parental

Cupertino affirme que le système a été conçu de telle sorte qu’un utilisateur n’a pas besoin de faire confiance à Apple pour savoir que le système « fonctionne comme annoncé » : « Le modèle de menace s’appuie sur les propriétés techniques du système pour se prémunir contre la possibilité peu probable de réviseurs malveillants ou contraints, et s’appuie à son tour sur les réviseurs pour se prémunir contre la possibilité d’erreurs techniques ou humaines plus tôt dans le système ».

La société a réaffirmé qu’elle refuserait les demandes d’ajout d’images non-CSAM à l’ensemble de données : « Apple refusera également toutes les demandes visant à donner des instructions aux examinateurs humains pour qu’ils déposent des rapports pour tout ce qui n’est pas du matériel CSAM pour les comptes qui dépassent le seuil de correspondance ».

Lors de l’annonce initiale, Apple a également annoncé que l’apprentissage automatique serait utilisé dans iMessage pour alerter les parents utilisant le partage familial lorsque les comptes des enfants ont regardé ou envoyé des images sexuellement explicites, ainsi que pour fournir des avertissements à l’enfant.

« Pour les comptes d’enfants âgés de 12 ans et moins, chaque image sexuellement explicite envoyée ou reçue préviendra l’enfant que s’il continue à regarder ou à envoyer l’image, ses parents recevront une notification. Ce n’est que si l’enfant continue à envoyer ou à regarder une image après cet avertissement que la notification sera envoyée », indique Apple. « Pour les comptes d’enfants âgés de 13 à 17 ans, l’enfant est toujours averti et il lui est demandé s’il souhaite visualiser ou partager une image sexuellement explicite, mais les parents ne sont pas avertis. »

Source : net.fr/actualites/